春节期间最火爆的新闻是DeepSeek,没有之一,这则消息足以震动全球。它是一款国产的开源大模型,APP登顶苹果中国区和美国区应用商店免费下载排行榜。其实早在去年12月份就发布了v3模型,但当时并不火,直到今年1月份发布了对标OpenAI-o1的推理模型r1,短短几天时间火爆全球。由于免费开源,且训练成本大幅下降的情况下达到差不多的效果,这在AI行业引发的广泛的关注和讨论,市场对以英伟达为首的「大力出奇迹」的训练方式产生了质疑,认为通过对模型的优化可以减少对高端芯片的需求,英伟达股价也因此暴跌。

一夜之间,微软、英伟达、亚马逊等全部接入DeepSeek模型。前两天,华为联合硅基流动首发了基于华为云昇腾云服务的DeepSeek-V3、DeepSeek-R1。硅基流动(SiliconCloud)是硅基流动公司推出的大模型云服务平台,目标是通过优化大模型,帮助用户实现Token自由,这是个收费产品,但是可以在线体验。

春节期间很多人已经体验了DeepSeek,手机端直接在应用商店下载使用,或者直接在网页体验:https://www.deepseek.com。但是也有一些深度用户,想在电脑端部署,离线使用。今天介绍一下如何在电脑上部署,为了方便操作可以首先安装一个名为“Ollama”的软件,它是一个开源框架,专门为本地电脑上部署和运行大模型而生的。

1.在Ollama的官网包含Ollama程序下载以及DeepSeek模型下载。官网地址:https://ollama.com

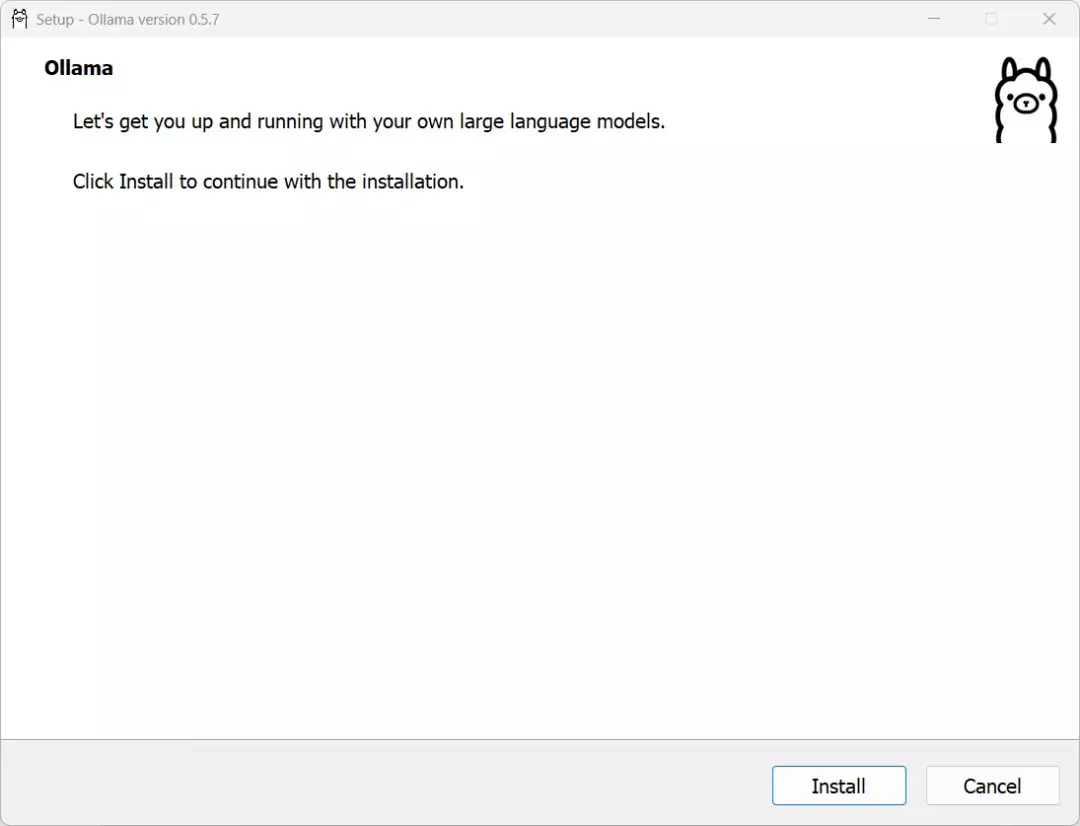

2.首先以管理员身份运行Ollama程序进行安装,然后使用命令进行部署DeepSeek模型。

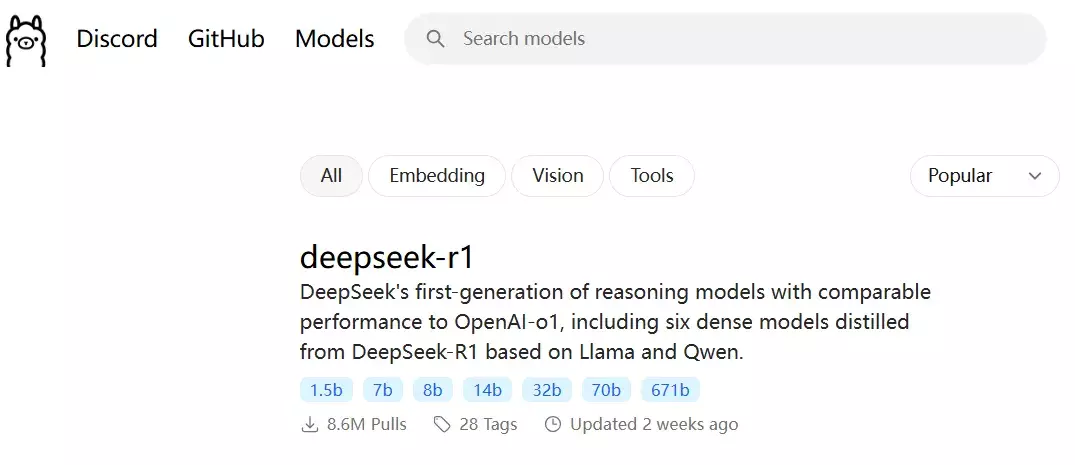

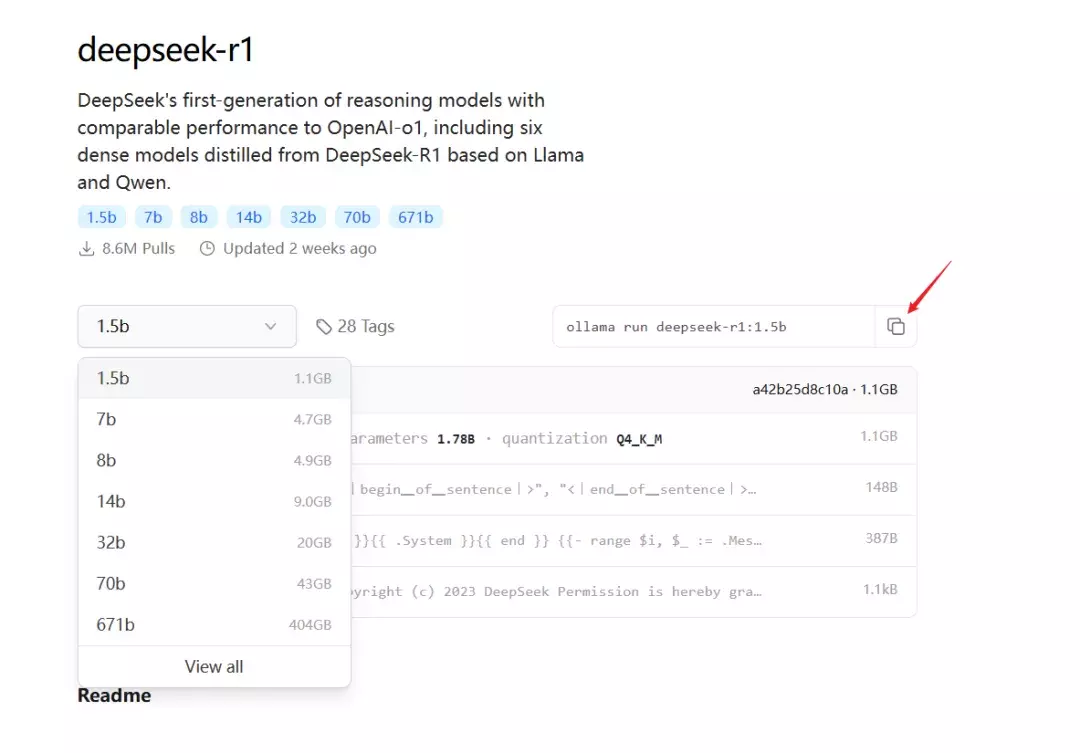

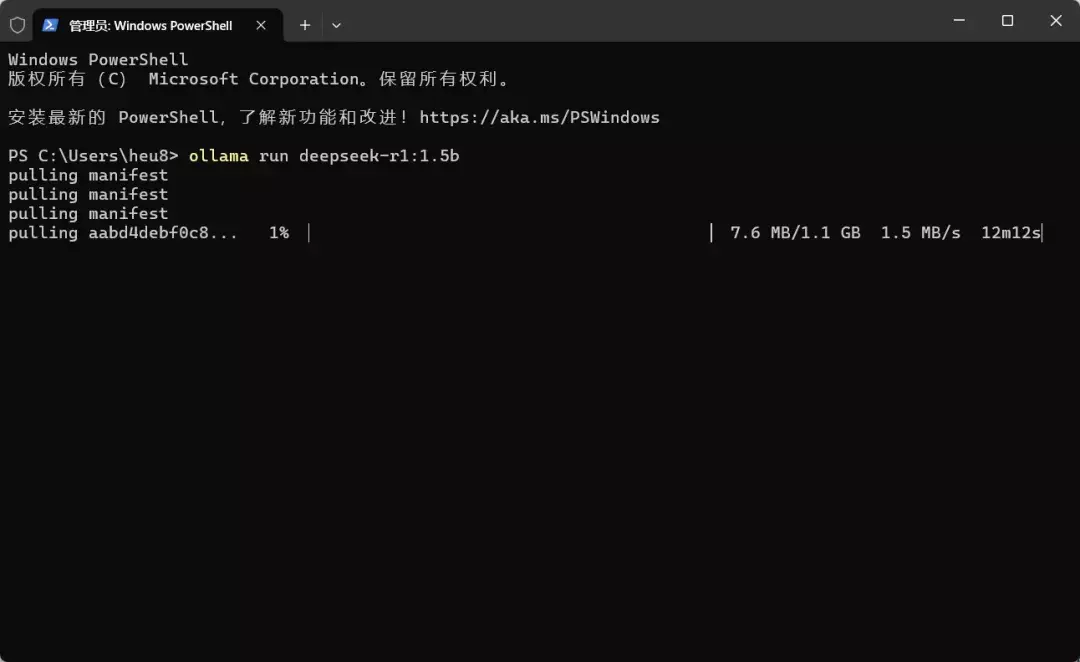

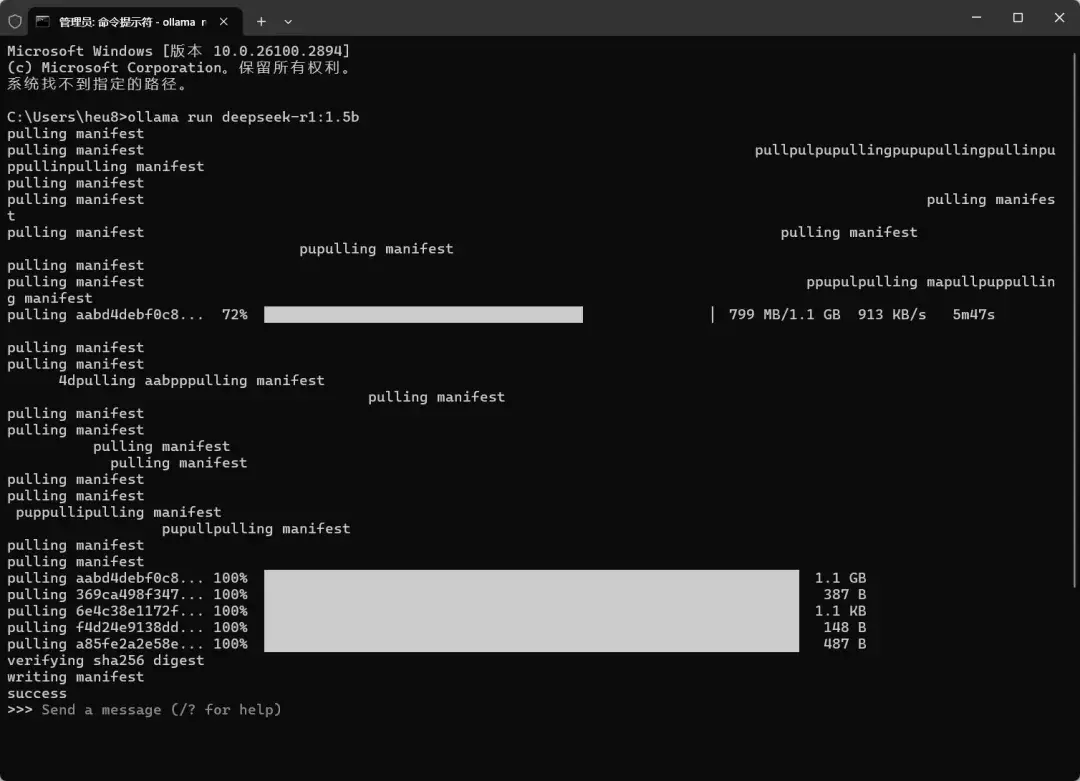

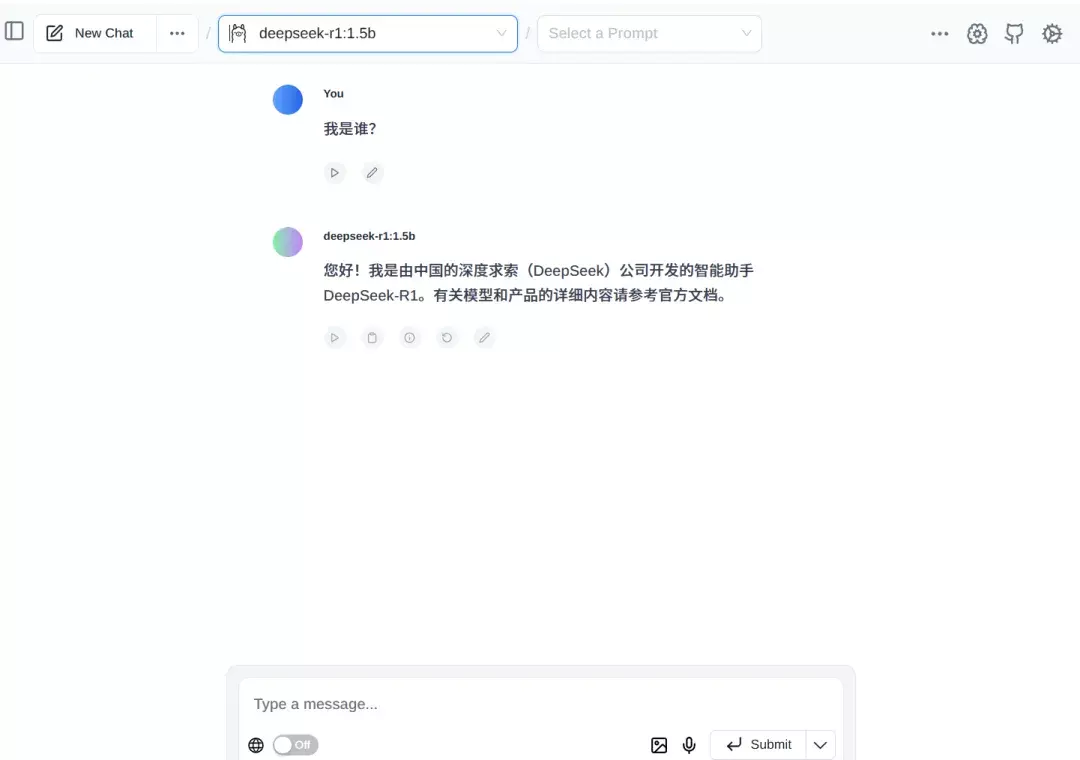

DeepSeek模型有多个版本:1.5b、7b、8b、14b、32b、70b 671b,版本越高对GPU要求越高。每一个版本都对应一个安装命令,复制下来。然后以管理员身份运行CMD命令,输入上述命令。例如:ollama run deepseek-r1:1.5b,则自动在线部署安装。

(备注:卸载则把命令中的run改成rm,如果想了解更多命令,则直接输入ollama查看)

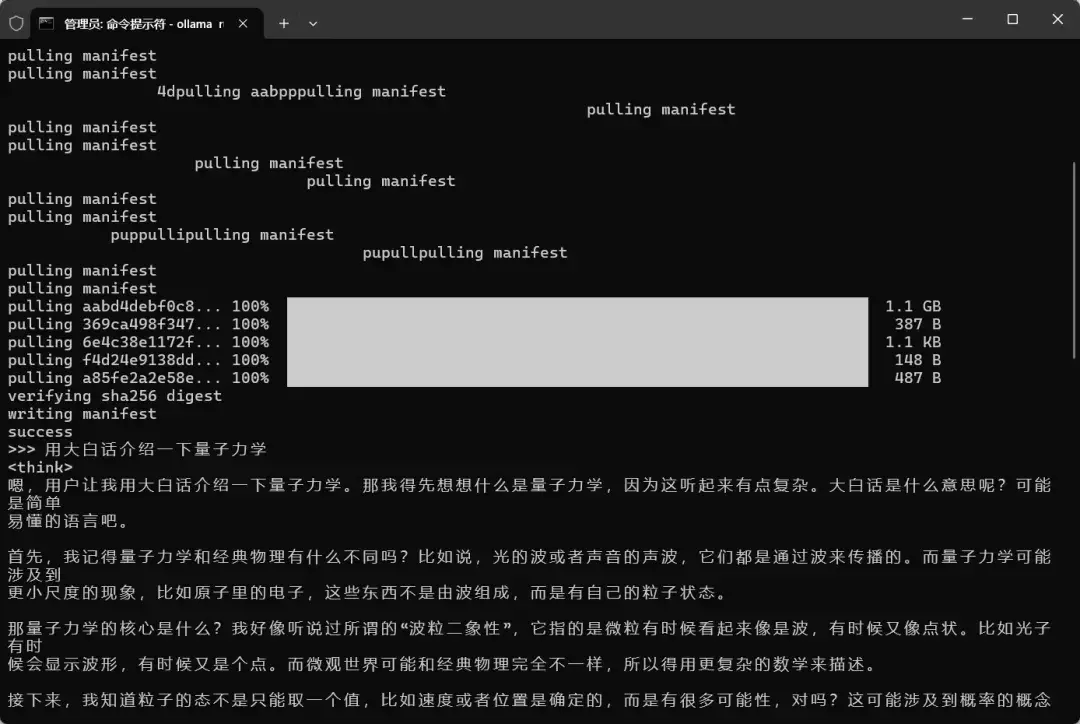

部署完成后,我们可以使用直接在命令窗口输入想问的问题。

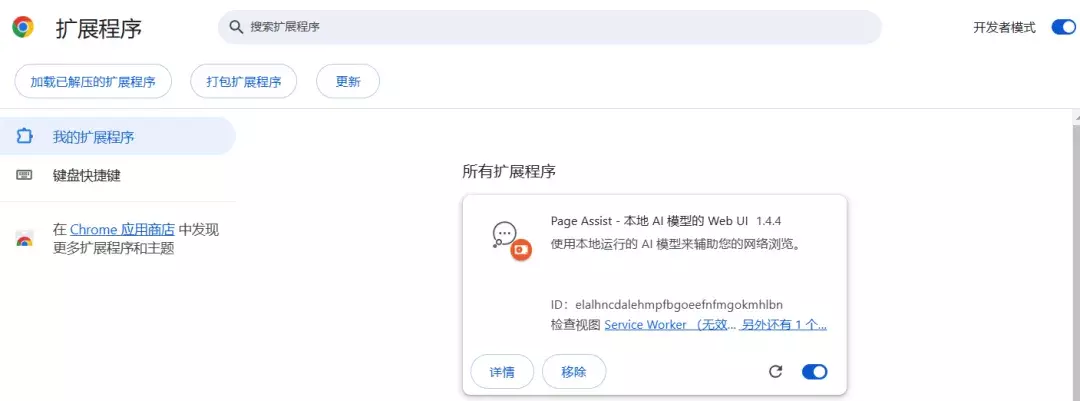

如果你觉得没有UI,使用起来不方便的话,也可以再安装一个浏览器插件。这里推荐一个pageassist插件(含Chrome和Firefox),插件的安装方法这里就不详细介绍了。

本地部署和在线使用各有利弊,本地对GPU配置要求较高,但运行稳定,不受网速影响。有需要的小伙伴可以体验一下~

所需软件下载链接:

https://pan.baidu.com/s/1ECJ8pKnNztPOLaY8r_vbHg?pwd=heu8 提取码:heu8

NobyDa

NobyDa

评论前必须登录!

立即登录 注册